Sintesi

Le prove indicano che informatici nordcoreani utilizzano la tecnologia deepfake in tempo reale per infiltrarsi nelle organizzazioni attraverso posizioni di lavoro remote, il che comporta rischi significativi per la sicurezza, la legge e la conformità. Le strategie di rilevamento delineate in questo report forniscono ai team responsabili di sicurezza e delle risorse umane una guida pratica per rafforzare i processi di assunzione e bloccare questa minaccia.

Nella nostra dimostrazione, è bastata poco più di un'ora, senza alcuna esperienza precedente, per capire come creare un deepfake in tempo reale utilizzando strumenti facilmente reperibili e hardware di consumo a basso costo. Questo permette agli antagonisti di creare facilmente identità sintetiche convincenti, consentendo loro di operare senza essere scoperti e potenzialmente di generare ricavi per regimi sanzionati.

Sebbene sia ancora possibile riscontrare limiti nell'attuale tecnologia deepfake, questi limiti stanno rapidamente diminuendo. Le organizzazioni devono implementare diversi livelli di difesa combinando procedure di verifica rafforzate, controlli tecnici e monitoraggio continuo durante il ciclo di vita dei dipendenti.

I clienti di Palo Alto Networks sono più protetti dalle minacce esaminate in questo articolo grazie ai Servizi per minacce interne della Unit 42.

Le organizzazioni possono coinvolgere il team di risposta agli incidenti della Unit 42 per ricevere assistenza specifica su questa e altre minacce.

Colloqui ai nordcoreani

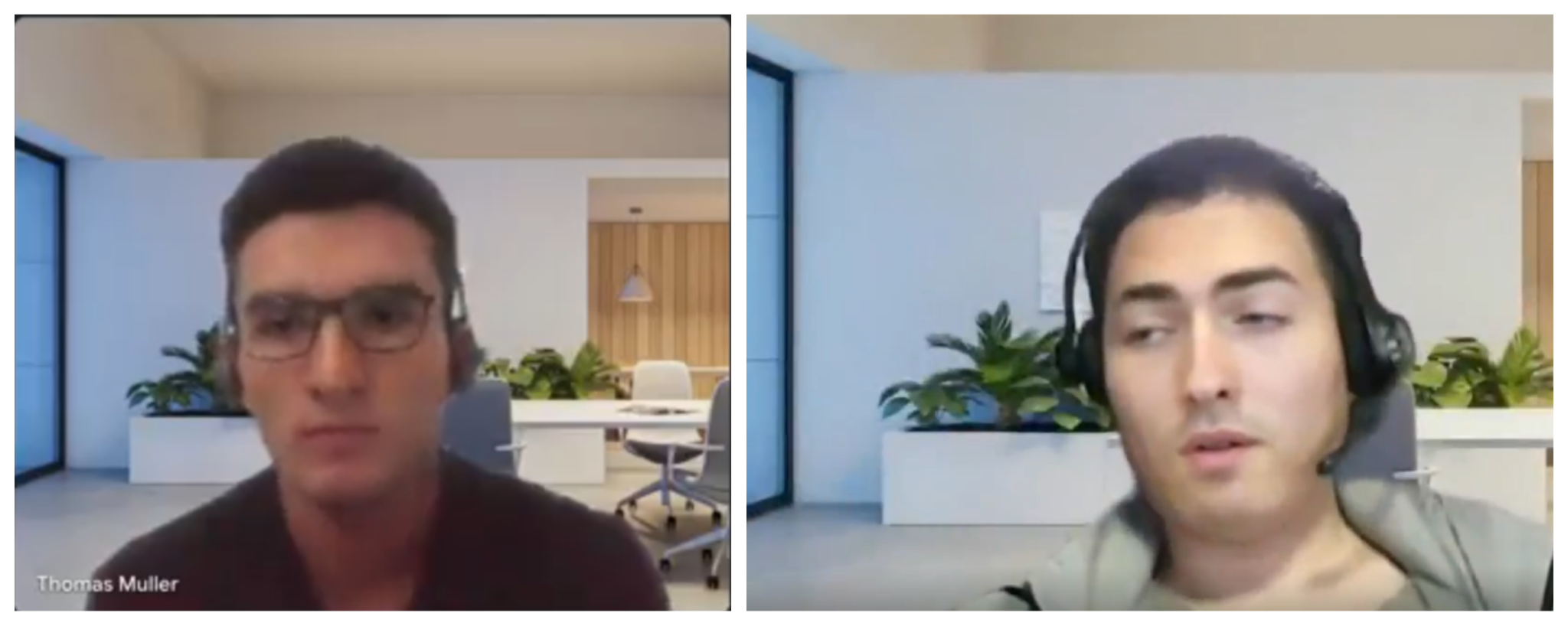

Le community che si occupano di acquisizione di talenti e cybersecurity hanno recentemente segnalato un'impennata di candidati che utilizzano deepfake in tempo reale durante i colloqui di lavoro. Gli investigatori hanno documentato casi in cui gli intervistati hanno presentato feed video sintetici, utilizzando sfondi virtuali identici per diversi profili di candidati, come mostrato nella Figura 1.

La newsletter Pragmatic Engineer ha documentato un caso di studio che coinvolge un'azienda polacca di intelligenza artificiale che si è imbattuta in due diversi candidati deepfake. Gli intervistatori hanno sospettato che fosse la stessa persona a gestire entrambi i profili, in particolare quando l'operatore ha mostrato una maggiore sicurezza durante il secondo colloquio tecnico dopo aver sperimentato in precedenza il formato e le domande del colloquio.

L'analisi degli indicatori della Unit 42, condivisa nel report di Pragmatic Engineer, si allinea con le tattiche, le tecniche e le procedure (TTP) note attribuite a operazioni di informatici della Repubblica Popolare Democratica di Corea (RPDC). Questo rappresenta una logica evoluzione del loro consolidato schema di infiltrazione sul lavoro fraudolento.

Gli attori di minacce nordcoreani hanno costantemente dimostrato un interesse significativo per le tecniche di manipolazione dell'identità. Nella nostra indagine 2023 abbiamo riferito dei loro sforzi per creare identità sintetiche supportate da informazioni personali compromesse, rendendo più difficile la loro individuazione.

Abbiamo trovato ulteriori prove quando abbiamo analizzato la violazione di Cutout.pro, un servizio di manipolazione di immagini AI, che ha rivelato decine di indirizzi e-mail probabilmente legati alle operazioni di informatici della RPDC. La Figura 2 mostra una manipolazione dell'immagine di questo tipo in scatti con scambio del volto.

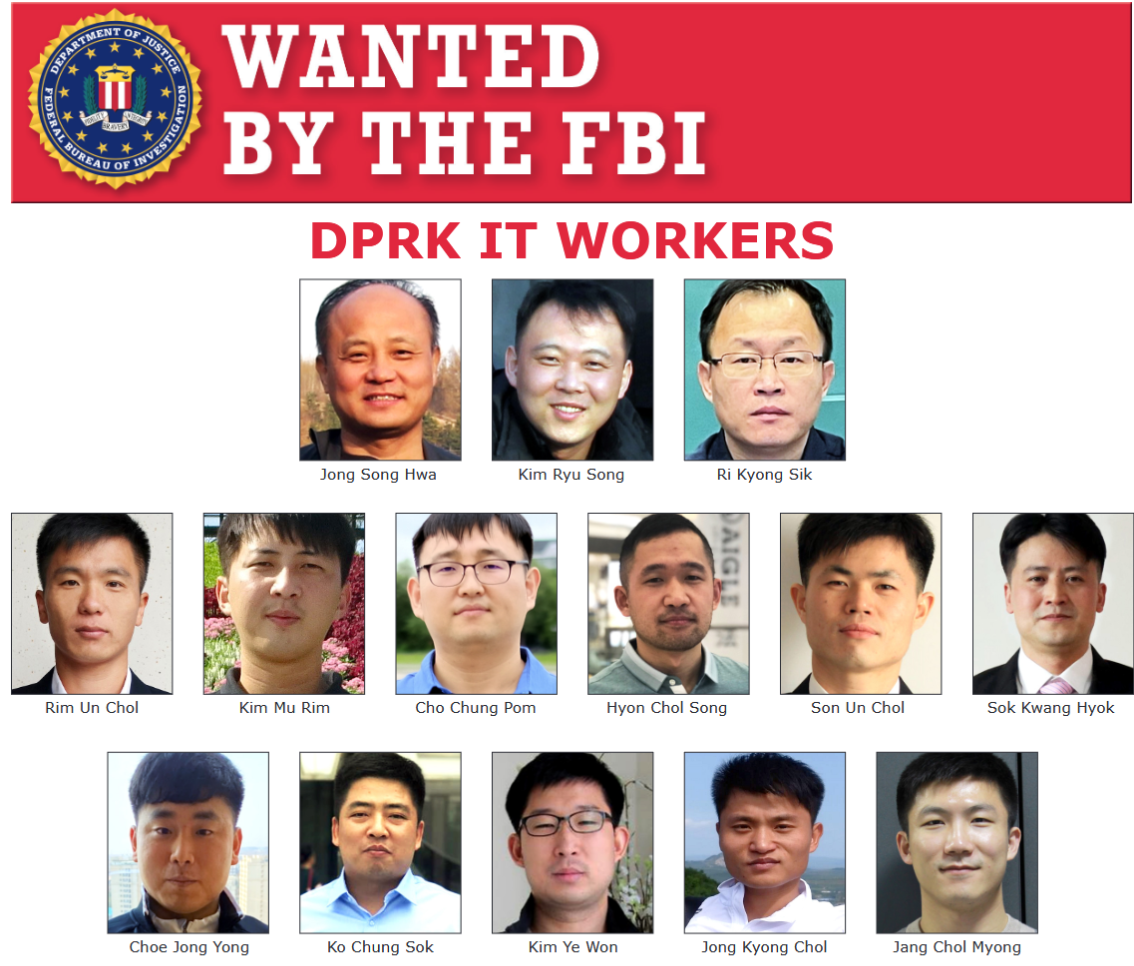

Gli informatici della RPDC hanno progressivamente perfezionato la loro metodologia di infiltrazione implementando la tecnologia deepfake in tempo reale. Questa offre due vantaggi operativi fondamentali. In primo luogo, consente a un singolo operatore di sostenere più volte un colloquio per la stessa posizione utilizzando diversi profili sintetici. In secondo luogo, aiuta gli operatori a evitare di essere identificati e inseriti nei bollettini della sicurezza e negli avvisi di ricercati, come quello mostrato nella Figura 3. Insieme, aiuta gli informatici della RPDC a usufruire di una maggiore sicurezza operativa e di una minore rilevabilità.

Da zero a passabile

Un singolo ricercatore senza esperienza nella manipolazione delle immagini, con conoscenze limitate di deepfake e un computer di cinque anni ha creato un'identità sintetica per i colloqui di lavoro in 70 minuti. La facilità di creazione dimostra quanto questa tecnologia sia diventata pericolosamente accessibile agli attori di minacce.

Utilizzando solo un motore di ricerca AI, una connessione Internet anche non estremamente performante e una GPU (unità di elaborazione grafica) GTX 3070 acquistata alla fine del 2020, hanno prodotto il campione mostrato nella Figura 4.

Figura 4. Una dimostrazione di un deepfake in tempo reale su un hardware economico e ampiamente disponibile.

Hanno utilizzato solo immagini singole generate da thispersonnotexist[.]org, che consente l'utilizzo dei volti generati per scopi personali e commerciali, oltre a strumenti gratuiti per deepfake. Con questi, hanno generato identità multiple, come mostrato nella Figura 5.

Figura 5. Una dimostrazione di cambio di identità.

Un semplice cambio di abbigliamento e immagine di sfondo potrebbe essere tutto ciò che serve per presentarsi a un responsabile delle assunzioni come un candidato nuovo di zecca. In effetti, la parte più lunga dell'intero processo è stata la creazione di un feed di videocamera virtuale per l'acquisizione nel software di videoconferenza.

Con un po' di tempo in più e un'unità di elaborazione grafica molto più potente, una versione a risoluzione più elevata dello stesso processo ha prodotto risultati più convincenti, come mostrato nella Figura 6.

Figura 6. Un deepfake di qualità superiore che utilizza una tecnica con un uso più intensivo di risorse.

Opportunità di rilevamento

I sistemi di deepfake in tempo reale presentano diverse carenze tecniche che creano opportunità di rilevamento:

- Problemi di coerenza temporale: i rapidi movimenti della testa hanno causato artefatti evidenti, poiché il sistema di tracciamento ha faticato a mantenere un posizionamento accurato dei punti di riferimento

- Gestione dell'occlusione: quando la mano dell'operatore passava sul volto, il sistema deepfake non riusciva a ricostruire correttamente il volto parzialmente oscurato

- Adattamento dell'illuminazione: i cambiamenti improvvisi nelle condizioni di illuminazione hanno rivelato incongruenze nel rendering, in particolare ai bordi del volto

- Sincronizzazione audiovisiva: un leggero ritardo tra i movimenti delle labbra e la voce era rilevabile con un'attenta osservazione

In questo momento, ci sono diversi modi per rendere la vita difficile ai cosiddetti deepfaker. Il metodo più efficace sembra essere quello di passare una mano sul volto, che interrompe il tracciamento dei punti di riferimento facciali.

Govind Mittal et al. of New York University suggeriscono ulteriori strategie:

- Movimenti rapidi della testa

- Espressioni facciali esagerate

- Improvvisi cambiamenti dell'illuminazione

Queste tecniche sfruttano i punti deboli dei sistemi di deepfake in tempo reale, causando artefatti visibili che aiutano gli esseri umani a rilevare profili falsi con elevata precisione.

Nelle Figure 7a-c mostreremo altre tre opzioni da aggiungere al repertorio dell'intervistatore.

Figura 7a. "Da orecchio a spalla".

Figura 7b. Lo "show del naso".

Figura 7c. Lo "sguardo verso il cielo o la terra".

Strategie di mitigazione

La campagna per gli informatici della RPDC richiede una stretta collaborazione tra i team addetti alle risorse umane (HR) e alla sicurezza delle informazioni. Quando collaborano, un'organizzazione ha maggiori opportunità di rilevamento nell'intero ciclo di vita dell'assunzione e dell'impiego.

Esclusione di responsabilità: Quelle che seguono sono strategie di mitigazione che intendono offrire spunti e suggerimenti per la riflessione del lettore. Tali informazioni sono fornite solo a scopo informativo e non devono essere considerate una consulenza legale. Prima di implementare una qualsiasi di queste pratiche, consultate il vostro consulente legale per confermare che siano in linea con le leggi vigenti.

Per team HR:

- Chiedere ai candidati di accendere le videocamere durante i colloqui, comprese le consultazioni iniziali

- Registrare queste sessioni (previo consenso) per potenziali analisi forensi

- Implementare un flusso di lavoro completo per la verifica dell'identità che includa:

- Verifica dell'autenticità dei documenti tramite strumenti forensi automatizzati che controllano le caratteristiche di sicurezza, gli indicatori di manomissione e la congruenza delle informazioni tra i documenti presentati

- Verifica dell'identità con rilevamento integrato della presenza della persona, che richiede ai candidati di presentare il proprio documento d'identità fisico durante l'esecuzione di azioni specifiche in tempo reale

- Corrispondenza tra i documenti d'identità e il candidato, per garantire che la persona intervistata corrisponda alla sua presunta identificazione

- Formare i reclutatori e i team tecnici addetti ai colloqui per identificare schemi sospetti nei colloqui video, come movimenti innaturali degli occhi, incongruenze nell'illuminazione e problemi di sincronizzazione audiovisiva

- Fare in modo che gli intervistatori si abituino a chiedere ai candidati di eseguire movimenti difficili per i software di deepfake (ad esempio, girarsi di profilo, gesti delle mani vicino al volto o movimenti rapidi della testa)

Per team di sicurezza:

- Proteggere la pipeline di assunzione registrando gli indirizzi IP delle domande di lavoro e verificando che non provengano da infrastrutture di anonimizzazione o da aree geografiche sospette

- Arricchire i numeri di telefono forniti per verificare se si tratta di operatori Voice over Internet Protocol (VoIP), in particolare quelli comunemente associati all'occultamento dell'identità

- Mantenere gli accordi di condivisione delle informazioni con aziende partner e partecipare ai centri di condivisione e analisi delle informazioni (ISAC) per rimanere aggiornati sulle ultime tecniche di identità sintetica

- Identificare e bloccare le applicazioni software che consentono l'installazione di webcam virtuali sui dispositivi gestiti dall'azienda quando non esiste una giustificazione aziendale legittima per il loro utilizzo.

Indicatori aggiuntivi:

- Monitorare gli schemi di accesso anomalo alla rete dopo l'assunzione, in particolare le connessioni a servizi di anonimizzazione o i trasferimenti di dati non autorizzati

- Implementare metodi di autenticazione a più fattori che richiedono il possesso fisico dei dispositivi, rendendo più difficile l'impersonificazione dell'identità

Considerazioni sulla politica dell'organizzazione:

- Sviluppare protocolli chiari per la gestione dei casi di sospetta identità sintetica, comprese le procedure di escalation e i metodi di conservazione delle prove

- Creare un programma di sensibilizzazione alla sicurezza che istruisca tutti i dipendenti coinvolti nelle assunzioni sui campanelli di allarme delle identità sintetiche

- Stabilire controlli tecnici che limitino l'accesso dei nuovi dipendenti fino al raggiungimento di ulteriori tappe di verifica

- Documentare i fallimenti della verifica e condividere gli indicatori tecnici appropriati con partner di settore e agenzie governative pertinenti

Implementando queste strategie di rilevamento e mitigazione a più livelli, le organizzazioni possono ridurre significativamente il rischio di infiltrazione di identità sintetiche, mantenendo un processo di assunzione efficiente per i candidati legittimi.

Conclusione

La minaccia dell'identità sintetica, tipica delle operazioni degli informatici della Corea del Nord, rappresenta una sfida in continua evoluzione per le organizzazioni di tutto il mondo. La nostra ricerca dimostra l'allarmante accessibilità alla creazione di identità sintetiche, con una continua riduzione delle barriere tecniche, man mano che i volti generati dall'intelligenza artificiale, gli strumenti di falsificazione dei documenti e le tecnologie di manipolazione vocale/video in tempo reale diventano più sofisticati e facilmente disponibili.

Man mano che le tecnologie di identità sintetica continuano ad evolversi, le organizzazioni devono implementare strategie di difesa a più livelli che combinino:

- Procedure di verifica rafforzate

- Contromisure assistite dall'intelligenza artificiale per il rilevamento di deepfake

- Verifica continua per tutta la durata del rapporto di lavoro

Questo approccio migliora significativamente la capacità di un'organizzazione di rilevare e mitigare non solo le minacce derivanti dagli informatici nordcoreani, ma anche una serie di minacce simili.

Nessun singolo metodo di rilevamento garantisce la protezione contro le minacce basate su identità sintetica, ma una strategia di difesa a più livelli migliora significativamente la capacità dell'organizzazione di identificare e mitigare questi rischi. Combinando le best practice per le risorse umane con i controlli di sicurezza, è possibile mantenere un processo di assunzione efficiente e allo stesso tempo proteggersi dalle tattiche sofisticate impiegate dagli informatici della Corea del Nord e da attori di minacce simili.

I clienti di Palo Alto Networks possono proteggersi meglio dalle minacce sopra descritte grazie ai Servizi per le minacce interne della Unit 42 per migliorare in modo olistico il rilevamento e la risoluzione.

Se pensate di essere stati compromessi o se avete una questione urgente, contattate il team di risposta agli incidenti della Unit 42 o chiamate:

- Nord America: Numero verde: +1 (866) 486-4842 (866.4.UNIT42)

- REGNO UNITO: +44.20.3743.3660

- Europa e Medio Oriente: +31.20.299.3130

- Asia: +65.6983.8730

- Giappone: +81.50.1790.0200

- Australia: +61.2.4062.7950

- India: 00080005045107

Palo Alto Networks ha condiviso questi risultati con i membri della Cyber Threat Alliance (CTA). I membri della CTA utilizzano queste informazioni per distribuire rapidamente le protezioni ai loro clienti e per bloccare sistematicamente attori informatici malintenzionati. Ulteriori informazioni sulla Cyber Threat Alliance.

Risorse aggiuntive

- Falso informatico nordcoreano collegato all'attacco di phishing dell'app di videoconferenza BeaverTail - Unit 42, Palo Alto Networks

- Le aziende globali pagano inconsapevolmente i nordcoreani: Ecco come catturarli - Unit 42, Palo Alto Networks

- Hackerare i datori di lavoro e cercare lavoro: Due campagne legate al mondo del lavoro hanno i tratti distintivi degli attori di minacce della RPDC - Unit 42, Palo Alto Networks

- Intervista contagiosa: Attori di minacce della RPDC in cerca di lavoro nel settore tecnologico per installare nuove varianti di malware BeaverTail e InvisibleFerret - Unit 42, Palo Alto Networks

- Gotcha: Rilevamento di video deepfake in tempo reale tramite sfida-risposta - Govind Mittal, Chinmay Hegde, Nasir Memon

- Impostori AI smascherati nel reclutamento di sviluppatori tecnologici: post mortem - Gergely Orosz, The Pragmatic Engineer

- Ecco cosa succede in un'intervista deepfake - Billy Hurley, IT Brew

- Le dinamiche emergenti delle campagne di truffa deepfake sul Web - Unit 42

Ricevi aggiornamenti da Unit 42

Ricevi aggiornamenti da Unit 42